IA: oggi ogni campo dell’attività umana deve fare i conti con i sistemi informatici intelligenti

di Katrin Bove

L’intelligenza artificiale (IA) è una disciplina che studia in che modo si possano realizzare sistemi informatici intelligenti in grado di simulare la capacità e il comportamento del pensiero umano. È esteso, a questo riguardo, il dibattito dal punto di vista etico. Nel 2014, Stephen Hawking, fra i più autorevoli e conosciuti fisici teorici al mondo, mise in guardia riguardo ai pericoli dell’intelligenza artificiale; che considerava una minaccia per la sopravvivenza dell’umanità.

Le origini dell’ IA come disciplina

Il primo passo che portò all’origine di questa disciplina fu l’avvento dei calcolatori. Già nel 1623 grazie a Wilhelm Schickard si arrivò a creare macchine in grado di effettuare calcoli matematici con numeri fino a sei cifre, anche se non in maniera autonoma.

Nel 1642 Blaise Pascal costruì una macchina in grado di fare operazioni utilizzando il riporto automatico; mentre nel 1674 Gottfried Wilhelm von Leibniz creò una macchina in grado di effettuare la somma, la differenza e la moltiplicazione in maniera ricorsiva.

Tra il 1834 e il 1837 Charles Babbage lavorò al modello di una macchina le cui caratteristiche anticiparono, in parte, quelle dei moderni calcolatori. Si trattava della macchina analitica

1900′: torna l’attenzione sui computer

Nel ventesimo secolo l’attenzione sui computer ritornò ad accendersi: nel 1937 Claude Shannon, all’università di Yale, mostrò come l’algebra booleana e le operazioni binarie potessero rappresentare il cambiamento circuitale all’interno dei telefoni.

Un ulteriore passo importante fu l’articolo di Alan Turing redatto nel 1936, “On Computable Numbers, With An Application To The Entscheidungs problem”, che pose le basi per concetti quali calcolabilità; computabilità; macchina di Turing; definizioni cardine per i calcolatori sino ai giorni nostri.

In seguito, nel 1943 McCulloch e Pitts crearono ciò che viene ritenuto il primo lavoro inerente all’intelligenza artificiale.

Lo studio sullo sviluppo di sistemi intelligenti

Nel 1956, al Dartmouth College (New Hampshire), si tenne un convegno al quale presero parte figure di spicco del nascente campo della computazione dedicata allo sviluppo di sistemi intelligenti. Erano presenti John McCarthy, Marvin Minsky, Claude Shannon e Nathaniel Rochester.

Su iniziativa di McCarthy un team di dieci persone avrebbe dovuto creare, in due mesi, una macchina in grado di simulare ogni aspetto dell’apprendimento e dell’intelligenza umana.

Il programma di Allen Newell e Herbert Simon

Nello stesso convegno, un’altra iniziativa catalizzò l’attenzione: il programma di Allen Newell e Herbert Simon. Questi due ricercatori, a differenza di McCarthy, avevano già un programma capace di qualche forma di ragionamento conosciuto con il nome di Logic Theorist, o LP; in grado di dimostrare teoremi partendo dai principi della matematica. Sempre nello stesso convegno, McCarthy introdusse l’espressione “intelligenza artificiale”.

Il programma creato da Newell e Simon permise loro di progredire e creare un programma chiamato General Problem Solver, o GPS. A differenza del LP, il GPS fu ideato con lo scopo di imitare i processi di risoluzione dei problemi utilizzati dagli esseri umani (nello specifico la cosiddetta “euristica mezzi-fini”).

Negli stessi anni, presso l’IBM, Rochester con dei suoi colleghi cominciò a sviluppare altri programmi capaci di ragionamento. Nel 1959, Herbert Gelemter creò il Geometry Theorem Prover, un programma in grado di dimostrare teoremi di geometria complessi. L’anno precedente, presso il MIT, McCarthy contribuì al campo dell’intelligenza artificiale definendo quello che per trent’anni fu riconosciuto come il linguaggio di programmazione dominante per la realizzazione dei sistemi di intelligenza artificiale: il LISP. McCarthy scrisse anche un documento intitolato Programs with Common Sense, nel quale descrive un programma ideale, chiamato Advice Taker, che può essere visto come il primo sistema intelligente completo.

Creare macchine in grado di esibire capacità di ragionamento umane

Tra le aspirazioni dei ricercatori vi era principalmente quella di creare macchine in grado di esibire capacità di ragionamento simili a quelle umane. Queste aspirazioni, però, dovettero scontrarsi con alcune difficoltà: prime fra tutte, l’assoluta mancanza di conoscenza semantica relativa ai domini trattati dalle macchine, in quanto la loro capacità di ragionamento si limitava a una mera manipolazione sintattica. A causa di questa difficoltà, nel 1966 il governo degli Stati Uniti d’America interruppe i fondi per lo sviluppo delle macchine traduttrici. Un ulteriore problema fu l’impossibilità di trattare molti problemi che l’intelligenza artificiale si era proposta. Questo perché si riteneva che “scalare” le dimensioni di un problema fosse solo una questione di hardware e memoria.

Questo tipo di ottimismo fu presto spento quando i ricercatori fallirono nel dimostrare teoremi a partire da più di una dozzina di assiomi. Si capì quindi che il fatto di disporre di un algoritmo che, a livello teorico, fosse in grado di trovare una soluzione a un problema non significava che un corrispondente programma fosse in grado di calcolarla effettivamente a livello pratico. Un terzo tipo di difficoltà furono le limitazioni alla base della logica, nel senso di ragionamento, dei calcolatori. Le precedenti difficoltà portarono a definire gli approcci adottati dalle macchine come approcci deboli, necessitando quindi di una conoscenza maggiore inerente al campo di applicazione.

Il programma DENDRAL

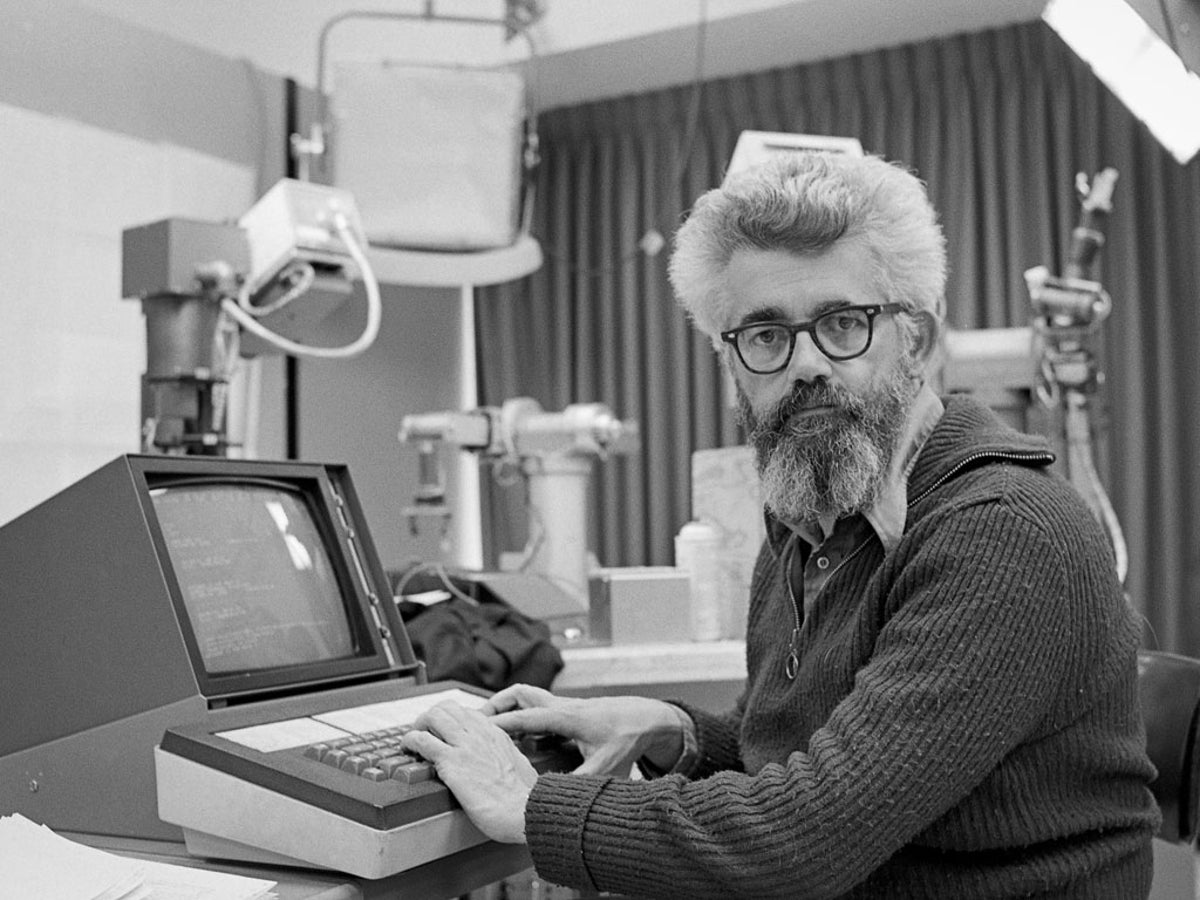

Nel 1969, grazie a Ed Feigenbaum (studente di Herbert Simon), Bruce Buchanam e Joshua Lederberg, fu creato il programma DENDRAL. In grado, a partire dalle informazioni sulla massa molecolare ricavate da uno spettrometro, di ricostruire la struttura di una molecola. Questo programma fu quindi il primo dei sistemi basati su un uso intensivo della conoscenza che arrivarono più tardi a inglobare tutti i concetti teorizzati da McCarthy per l’Advice Taker. Successivamente, Feigenbaum cominciò, insieme con altri ricercatori di Stanford l’Heuristic Program Project (HPP), ad estendere gli scenari applicativi di questi sistemi. Si teorizzarono i sistemi conosciuti come sistemi esperti, ovvero in grado di possedere una conoscenza esperta in un determinato scenario di applicazione.

Il primo sistema di IA in ambito commerciale

Il primo sistema di intelligenza artificiale utilizzato in ambito commerciale fu R1, utilizzato dalla Digital Equipment nel 1982. Lo scopo del programma era quello di aiutare a configurare gli ordini per nuovi computer.

A metà degli anni ottanta dello scorso secolo fu reinventato l’algoritmo di apprendimento per reti neurali chiamato back-propagation, inizialmente ideato nel 1969 da Bryson e Ho. L’algoritmo fu applicato a molti problemi relativi all’apprendimento, inerenti sia al lato dell’informatica sia a quello della psicologia. I cosiddetti modelli connessionisti per la realizzazione di sistemi intelligenti furono visti come alternativi ai modelli simbolici ideati da Newell e Simon, da McCarthy e dai loro collaboratori. Tali modelli cercarono di dare risposta a quelle domande alle quali i precedenti modelli non erano riusciti, ma in parte fallirono anch’essi. Di conseguenza, i modelli basati sull’approccio simbolico e quelli con un approccio connessionista furono visti come complementari.

Al giorno d’oggi i sistemi intelligenti sono presenti in ogni campo, anche nelle attività quotidiane. Primeggiano nei giochi, come teorizzato anni prima dagli esponenti dell’intelligenza artificiale.